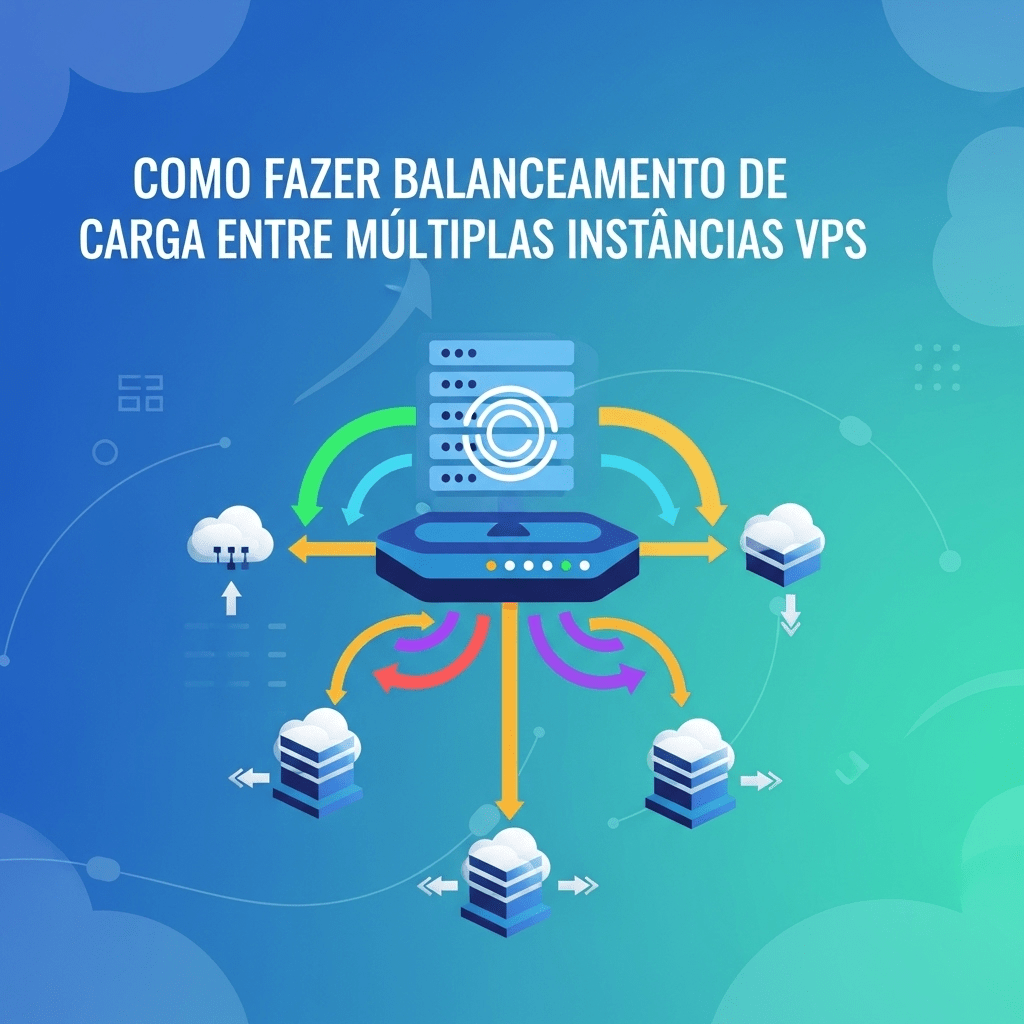

À medida que aplicações web, APIs, plataformas SaaS ou serviços online crescem, tanto em número de acessos quanto em complexidade, surge a necessidade de garantir que elas continuem rápidas, confiáveis e escaláveis. O balanceamento de carga torna-se uma peça-chave nessa evolução.

Em essência, balanceamento de carga (load balancing) é a técnica de distribuir solicitações ou tráfego entre múltiplos servidores, para que nenhum fique sobrecarregado e todos operem de forma eficiente. Quando falamos de VPSs — servidores virtuais privados — esse balanceamento permite multiplicar o poder computacional, diversificar pontos de falha, melhorar tolerância a falhas, latência e custo-benefício.

2. Por que usar múltiplas instâncias VPS

Alguns benefícios claros:

- Desempenho melhorado e latência reduzida: Com várias instâncias você pode atender requisições mais rapidamente, especialmente se elas estiverem geograficamente próximas aos usuários.

- Alta disponibilidade: Se uma instância falhar, as demais continuam operando. Isso reduz tempo de indisponibilidade.

- Escalabilidade horizontal: Em vez de melhorar muito uma única máquina (“scale up”), você adiciona mais instâncias (“scale out”), distribuindo a carga.

- Flexibilidade de custo: VPSs permitem pagar por recursos utilizados, arrancar novos ou desligar quando não precisarem.

- Resiliência geográfica: Possibilidade de distribuir servidores em diferentes regiões ou data centers para diminuir impacto de falhas regionais ou latência de rede.

Contudo, tudo isso traz complexidade extra: sincronização de dados, gerenciamento de sessões, monitoramento, segurança.

3. Algoritmos de balanceamento de carga

A escolha do algoritmo influencia diretamente o equilíbrio entre simplicidade, eficiência, overhead e adequação ao tipo de carga. Abaixo os mais comuns, com vantagens e pontos de atenção:

| Algoritmo | Descrição | Vantagens | Desvantagens |

|---|---|---|---|

| Round Robin | Envia cada requisição sequencialmente para os servidores da lista (servidor 1, 2, 3, depois volta ao 1). | Simples, fácil de configurar, bom para servidores com capacidades iguais. | Não considera carga atual ou desempenho individual. Se um servidor estiver com problema ou lento, mesmo assim receberá requisições. |

| Weighted Round Robin | Variante do Round Robin, mas com pesos: servidores mais potentes ou com mais recursos recebem mais requisições. | Permite lidar com instâncias heterogêneas; melhora o uso de servidores mais robustos. | Pesos precisam ser ajustados manualmente; pode não reagir bem a flutuações dinâmicas de carga. |

| Least Connections | Direciona nova requisição para o servidor com menor número de conexões ativas. | Boa para cargas variáveis, onde algumas requisições duram muito mais que outras. | Pode haver desequilíbrio se um servidor tiver muitas conexões de longa duração; não considera outros aspectos (CPU, RAM, latência). |

| Weighted Least Connections | Combina least connections com pesos, levando em conta capacidades diferentes dos servidores. | Mais adaptativo; tenta evitar sobrecarga em servidores mais fracos. | Mais complexo de configurar; métricas de carga e desempenho precisam ser monitoradas com boa qualidade. |

| IP Hash / Sticky Sessions | Usa o IP do cliente (ou outro identificador) para garantir que ele sempre vá para o mesmo backend. | Essencial quando sessões ou estado local importa (login, carrinho de compras, etc.). | Pode causar desequilíbrio; instâncias podem receber muitos “sticky” se muitos usuários vierem de mesmas faixas de IP; também, problemas se o cliente mudar de IP ou usar NAT. |

| Path-based / URL-based routing | Requisições para determinados caminhos (URLs) vão para instâncias específicas. | Permite distribuir tarefas especializadas (por exemplo, uma instância que só serve arquivos estáticos, outra que roda lógica pesada). | Requer configuração mais complexa; manutenção pode ser mais trabalhosa se rotas mudarem com frequência. |

| Latency-based / Geographical | Direciona usuários para instâncias mais próximas ou com menor latência. | Melhora experiência do usuário globalmente; útil em setup multi-região. | Requer infraestrutura distribuída; testes e monitoramento de latência; cuidado com consistência e sincronização de dados. |

Fontes reforçam a utilidade desses algoritmos: no contexto de VPS, usar least connections ou weighted costuma trazer ganhos perceptíveis quando há variabilidade de carga entre requisições.

4. Ferramentas e tecnologias relevantes

Para implementar o balanceamento entre VPSs, as seguintes ferramentas e tecnologias são bastante usadas e maturas:

- HAProxy: ótimo desempenho, muitos recursos, capacidade de balanceamento nas camadas de rede (TCP/UDP) e de aplicação (HTTP/S). Muito usado em setups de produção exigentes.

- Nginx: frequentemente usado como proxy reverso e load balancer HTTP/S. Menos funcionalidades avançadas que HAProxy no TCP puro, mas excelente para web, cache, SSL/TLS, etc.

- Traefik: moderno, boa integração com orquestradores de container (Docker, Kubernetes), configuração dinâmica.

- Seesaw: focado em capacidade de rede (L4), usado em grandes ambientes privados ou híbridos.

- Balance (inlab’s Balance) — ferramenta simples de proxy TCP com round robin e failover. Pode ser útil em setups menores.

- Serviços gerenciados / cloud: muitos provedores oferecem balanceadores como serviço, o que reduz trabalho operacional, mas pode ter custo superior.

5. Arquitetura recomendada

Para um sistema bem desenhado de balanceamento de carga com múltiplas VPSs, uma arquitetura típica pode ser assim:

[ Clientes / Usuários ]

│ HTTPS / HTTP / TCP etc.

▼

[Load Balancer(s)] ←– opcionalmente com redundância (active-active ou active-passive)

│

├───> [VPS Backend 1]

├───> [VPS Backend 2]

├───> [VPS Backend 3]

│ ...

└───> [VPS Backend N]

Componentes auxiliares:

- Health Checks: endpoints nos backends para verificar se estão saudáveis.

- Monitoramento: métricas de latência, carga CPU/RAM, número de conexões, tempo de resposta, erros.

- Sincronização de estado / dados: se há sessões, uploads ou arquivos, considerar uso de armazenamento compartilhado ou baseado em replicação.

- Caching: cache de requisições, assets estáticos, uso de CDN.

- Segurança: SSL/TLS, firewall, isolamento entre backends e balanceador, controle de acesso.

Redundância no balanceador:

- Active-Passive: um balanceador principal recebe tráfego, há outro preparado para assumir em caso de falha.

- Active-Active: dois ou mais balanceadores ativos, para distribuir carga de entrada e maior tolerância. Requer sincronização de configuração e estado.

Georredundância:

- Distribuir instâncias e balanceadores em múltiplas regiões ou data centers, para tolerância de falhas regionais e menor latência para usuários globais.

6. Configurações práticas e casos de uso

Aqui vão alguns exemplos de configurações que ilustram como colocar tudo isso em prática.

Caso: Aplicação Web com Alto Tráfego

- Três VPSs backend idênticas, cada uma rodando aplicação web.

- Um ou dois balanceadores HAProxy ou Nginx, com algoritmo least connections ou weighted least connections, definindo pesos conforme CPU/RAM.

- Health checks configurados para verificar um endpoint como

/healthou/status. - Sessões armazenadas externamente via Redis ou similar, para evitar dependência do backend.

- Arquivos estáticos servidos via CDN; uploads, logs sincronizados ou armazenados em sistema compartilhado (NFS, S3-like).

Caso: Microserviços / Containers

- Cada microserviço pode ter múltiplas instâncias em VPSs ou containers.

- Uso de ingress controllers (em Kubernetes, ou setups equivalentes) com Traefik ou Nginx-Ingress.

- Balanceamento baseado em path ou domínio (por exemplo,

/api/*para instâncias de API,/static/*para serviço de arquivos estáticos). - Observabilidade com métricas por serviço (ex: Prometheus + Grafana), logs centralizados.

Caso: Escalonamento Dinâmico

- Instâncias backend que podem ser adicionadas ou removidas conforme demanda.

- Balanceador que reconhece automaticamente novas instâncias (ou via script / orquestrador).

- Algoritmo que ajusta peso ou número de conexões conforme capacidade.

- Monitoramento e alertas para criação de novas instâncias quando carga ultrapassa certos limiares.

7. Monitoramento, métricas e manutenção

Para garantir que o balanceamento esteja funcionando bem ao longo do tempo, e que o sistema continue saudável, algumas práticas importantes:

- Coletar métricas: número de requisições por backend, latência, tempo de resposta, uso de CPU/RAM, uso de disco I/O, número de conexões ativas, taxa de erros (5xx, 4xx).

- Graficos/trends: visualização histórica para detectar degradação de desempenho.

- Alertas: quando uma instância estiver muito sobrecarregada, quando latência aumenta, quando taxas de erro sobem, ou quando health checks falham.

- Simulação de falhas: testar o que acontece quando um backend cai, ou um balanceador cai. Verificar se o tráfego é redirecionado corretamente, se há queda de sessão ou interações ruins para o usuário.

- Manutenção de software: garantir que versões dos backends sejam compatíveis, aplicar patches de segurança, backups, etc.

8. Desafios avançados e soluções

Além dos pontos usuais, quando se escala bastante ou se exige alta confiabilidade, surgem desafios mais complexos:

- Consistência de dados entre backends: uploads, logs, arquivos temporários. Solução: armazenamento compartilhado ou replicado, uso de objetos em nuvem, uso de CDN.

- Sessões persistentes ou estado do usuário: sticky sessions ou, preferível, tornar a aplicação stateless tanto quanto possível, com sessões armazenadas fora do servidor (por exemplo, Redis ou banco de dados dedicado).

- Latência inter-instâncias e replicação de banco: se instâncias VPS estiverem muito distantes, replicar bancos ou sincronizar dados pode gerar atrasos ou inconsistência.

- Gerenciar tráfego SSL/TLS / offloading: balanceador pode assumir terminação SSL para aliviar os backends; mas é importante proteger comunicação entre balanceador e instâncias.

- Proteção contra picos súbitos (spikes): auto-scaling, filas, controle de burst.

- Segurança elevadas: rate limiting, WAF (Web Application Firewall), proteção contra DDoS, isolamento adequado de rede, etc.

9. Escalabilidade, alta disponibilidade e redundância

Para sistemas de produção, é importante planejar desde o início para escalabilidade e tolerância a falhas.

- Escalabilidade horizontal: facilidade de adicionar mais VPSs conforme demanda aumenta. Automatização (via scripts, orquestrador, API do provedor).

- Alta disponibilidade (HA): múltiplos balanceadores para evitar que o balanceador seja ponto único de falha. Pode-se usar keepalived, VRRP, IPs virtuais, ou serviços gerenciados que têm HA embutido.

- Redundância geográfica: distribuir servidores em regiões diferentes, com replicação de dados. O DNS geográfico ou balanceamento global pode ajudar.

- Failover automático: se uma instância ou balanceador falhar, o sistema deve detectar e redirecionar tráfego sem intervenção manual.

10. Considerações finais

Balanceamento de carga entre múltiplas instâncias VPS não é apenas questão de adicionar servidores — envolve escolher os algoritmos certos, manter consistência de dados, garantir sessões funcionais, segurança, monitoramento e muito mais.

Quando bem feito: melhora bastante a experiência do usuário, reduz custos a longo prazo (evitando ter que superdimensionar uma única máquina), e permite crescimento sustentável.

É recomendável:

- Estudar bem o perfil de tráfego da aplicação (quantidade de requisições simultâneas, duração média das requisições, picos, distribuições geográficas).

- Começar com uma arquitetura simples, depois evoluir para setups mais sofisticados conforme necessidade.

- Integrar boas práticas de observabilidade e automação desde o início.

- Revisar frequentemente a arquitetura: o que funcionou quando havia 100 usuários pode não servir para 10.000.